在使用 AMD 显卡机器 安装 ollama 跑 DeepSeek-r1 大模型时候,发现它用的是CPU和内存,导致CPU直接占用 90%,并且速度还不是很理想。于是在网上找了一些教程,发现 AMD 显卡也是可以直接跑大模型的,这里做一下记录。

一、验证 ollama 是否使用显卡

- 查看 ollama 日志

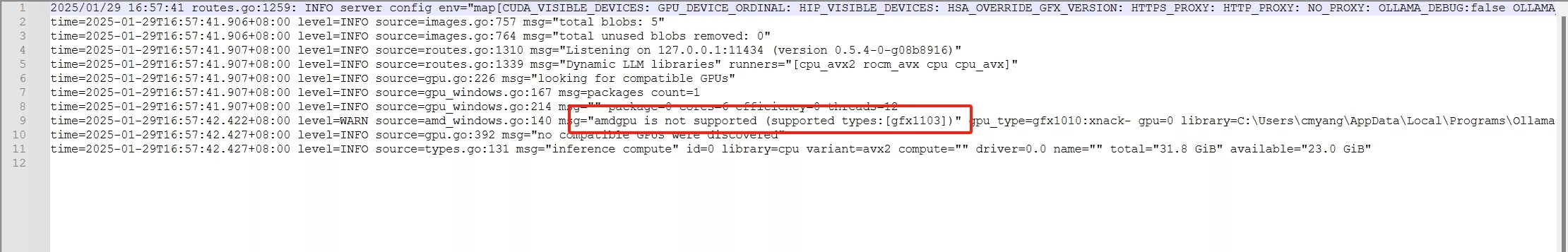

打开 ollama 的 server.log,会发现当前amd显卡不支持,并且输出了你的显卡的类型

gfx1010这个会用到。

- 直接运行大模型

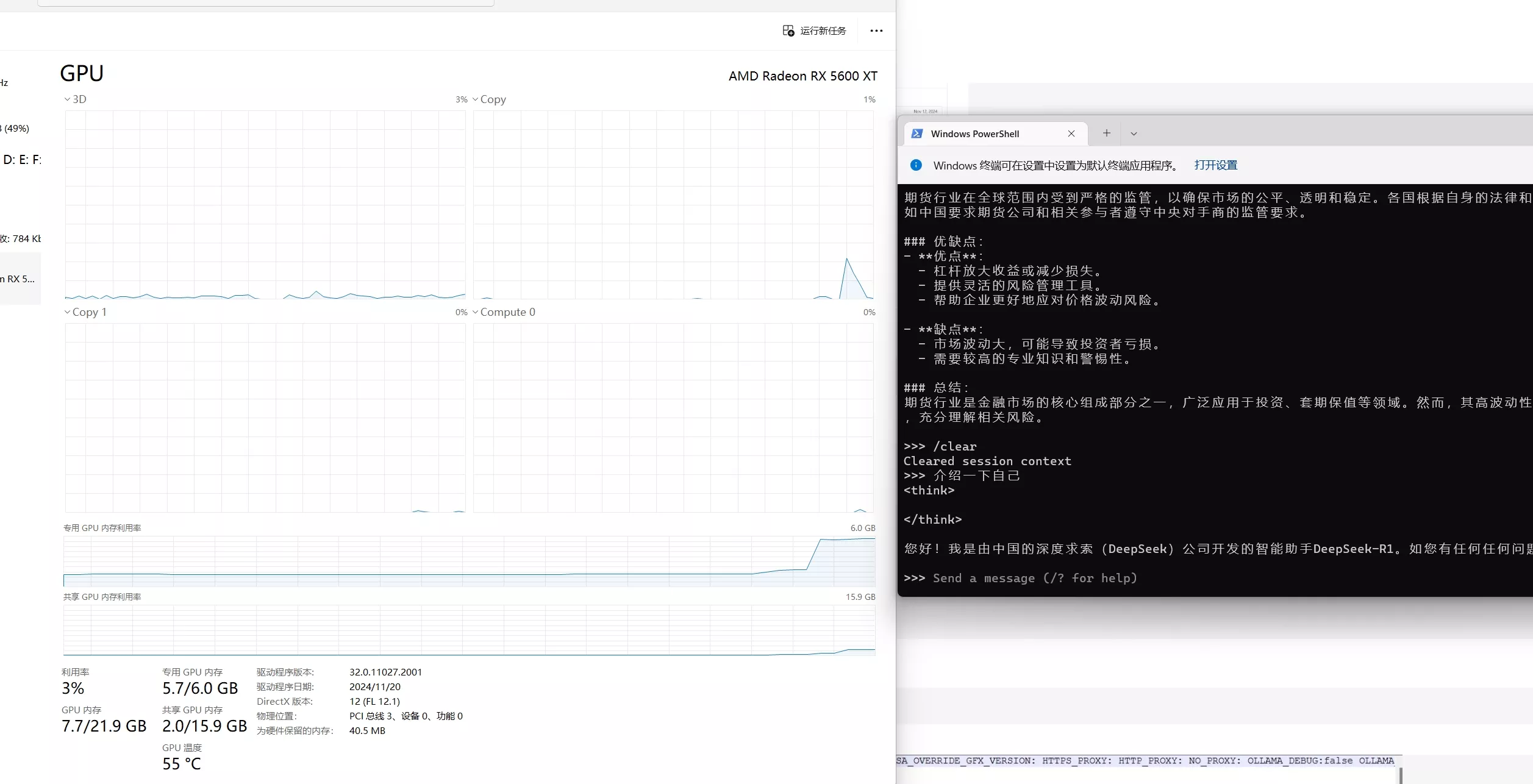

可以直接运行大模型,然后问它问题,查看 CPU 和 GPU 的占用。

二、教程

-

首先确认直接的 amd 显卡是否支持 ROCm

访问:rocm.docs.amd.com,查看是否有你的显卡型号,如果有,再看列表后面的 HIP SDK 是否为打勾,两者满足时直接下载并安装 AMD 官方版本的 ROCm 和 Ollama 的官方版本就能使用。

如果不支持,就要用下面的方法

-

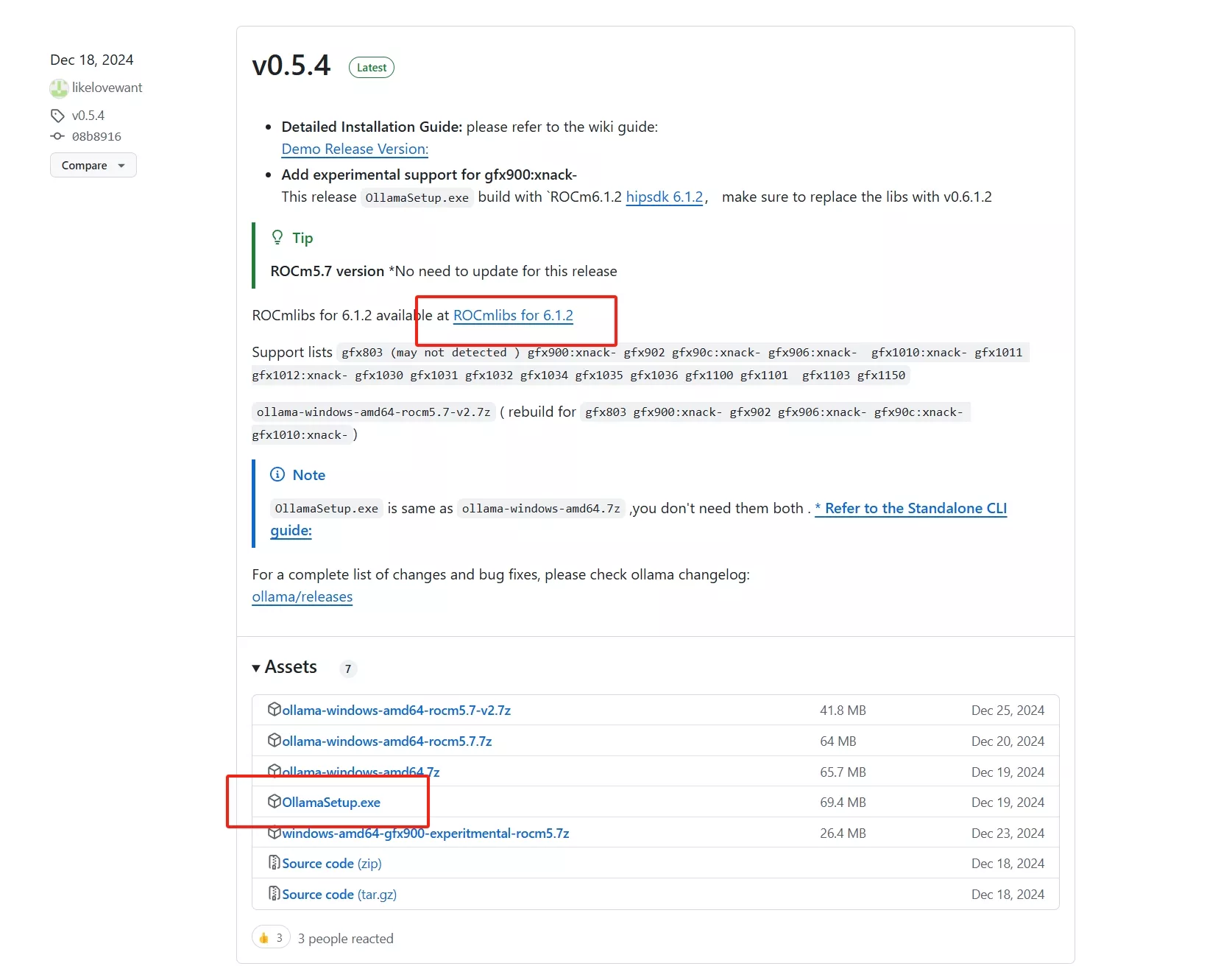

安装 ollama-for-amd

下载地址:ollama-for-amd

安装前,要卸载之前安装的 ollama -

下载 ROCmlibs for 6.1.2

下载地址:ROCmlibs for 6.1.2

这里下载的 rocmlib2 要根据之前看到的自己的gpu类型,如我的即:

gfx1010

- 替换文件

解压刚才下载的 rocmlibs for 6.1.2,替换相应文件到 ollama 安装目录。

ollama 安装目录:C:\Users\更换为你的电脑用户名\AppData\Local\Programs\Ollama\lib\ollama

压缩包的rocblas.dll替换ollama安装目录下的:C:\Users\更换为你的电脑用户名\AppData\Local\Programs\Ollama\lib\ollama\rocblas.dll

压缩包中的library文件夹替换ollama安装目录下的:C:\Users\更换为你的电脑用户名\AppData\Local\Programs\Ollama\lib\ollama\rocblas\library

- 重启ollama

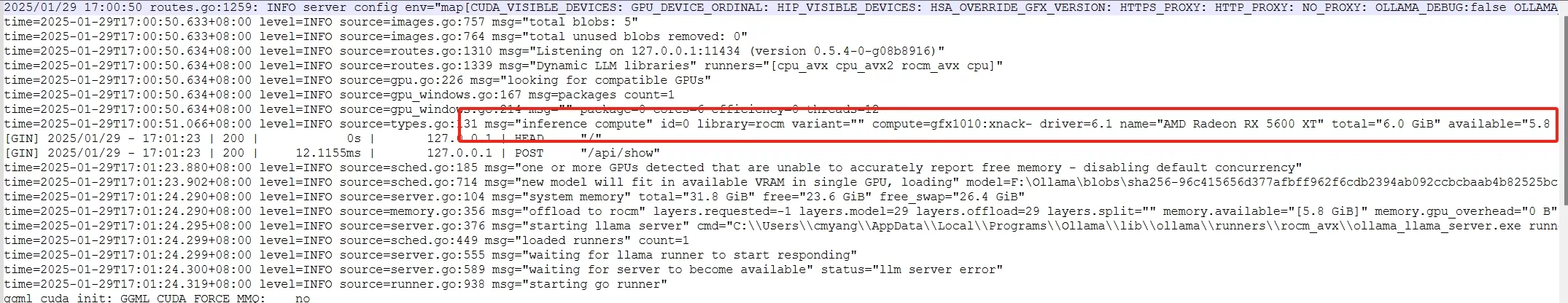

重新运行 ollama ,查看 server.log 日志

这里看,已经能够显示出 GPU 的信息了。

运行大模型并且提问,发现已经能正常使用GPU进行推理了。

评论区